La nueva arquitectura de HDD busca aumentar el throughput hasta 4×, apuntando a cargas masivas en centros de datos e infraestructura de IA.

Western Digital describe una arquitectura de discos duros optimizada para multiplicar el throughput hasta 4×, apuntando a cargas masivas donde el cuello de botella no es la capacidad, sino el ancho de banda.

HDD con rendimiento “flash-like”: qué anunció WD

Western Digital presentó oficialmente una nueva arquitectura de disco duro enfocada en maximizar rendimiento secuencial mediante tecnologías como HBDT (High Bandwidth Data Transfer) y un sistema de dual actuator pivot.

Según la compañía, esta combinación puede ofrecer hasta 4× más throughput frente a diseños HDD tradicionales, apuntando a un escenario donde el almacenamiento de gran escala necesita mover más datos por unidad de tiempo. (Fuente oficial: Western Digital · Cobertura: PC Gamer)

Qué significa realmente “tipo flash” (y qué no)

“Flash-like” es una frase potente, pero hay que aterrizarla: no significa que un HDD vaya a igualar la latencia de un SSD NVMe, ni que el acceso aleatorio de un disco mecánico se convierta mágicamente en flash.

La promesa va por otro lado: throughput secuencial y rendimiento agregado para cargas masivas. En especial:

- Transferencias grandes y sostenidas (streaming de datos).

- Workloads donde importa mover “mucho” más que acceder “rápido” a pequeños bloques.

- Entornos de centro de datos donde el costo por TB sigue mandando.

En otras palabras: WD está apostando a que el disco duro evolucione donde todavía tiene ventaja histórica: capacidad, costo por terabyte y escalabilidad, pero sin quedarse atrás en ancho de banda.

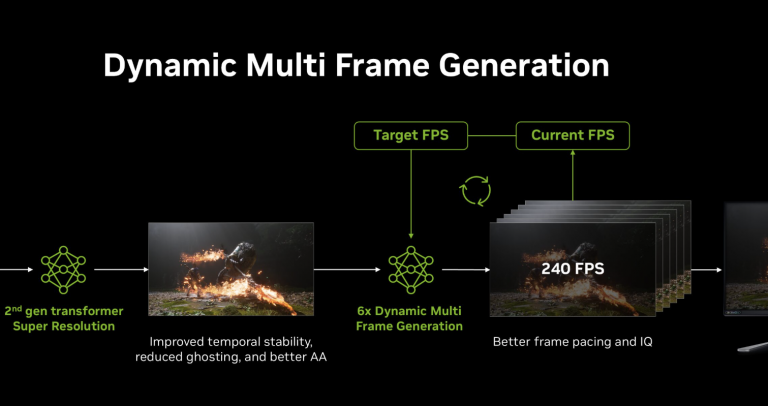

Dual actuator + HBDT: la lógica técnica

El uso de un sistema de doble actuador permite que el disco atienda múltiples zonas en paralelo, reduciendo cuellos de botella típicos del movimiento mecánico cuando el dispositivo tiene que “saltar” entre regiones del plato. En términos simples: más paralelismo para sostener mayor transferencia efectiva.

Por su parte, HBDT apunta a optimizar la ruta de datos dentro del propio disco, buscando exprimir más ancho de banda en el pipeline de transferencia. El resultado que WD quiere vender es claro: más throughput sin renunciar a densidad.

Este enfoque recuerda a estrategias previas en la industria (como familias con doble actuador tipo MACH.2), pero aquí el discurso se orienta con fuerza a data center y cargas de trabajo ligadas a IA y almacenamiento masivo.

¿Una salida parcial a la presión de memoria?

El contexto importa, la demanda de infraestructura para inteligencia artificial y centros de datos ha puesto presión sobre múltiples partes de la cadena—capacidad productiva, costos y prioridades de asignación—, un fenómeno que analizamos en profundidad en nuestra guía del ecosistema de semiconductores 2026. En ese escenario, una alternativa de alto throughput basada en HDD podría aliviar parte del estrés en almacenamiento masivo, especialmente donde el flash resulta caro.

No sustituye al SSD en sistemas operativos o gaming —un segmento que además enfrenta presión estructural por reasignación de capacidad hacia centros de datos, como explicamos en nuestro análisis sobre cómo el

PC gaming dejó de ser prioridad en la crisis de RAM—pero sí podría ser clave en:

- Datasets masivos y repositorios de entrenamiento (cuando el patrón es más secuencial que aleatorio).

- Backups de gran escala y almacenamiento a largo plazo.

- “Cold storage” que necesita más rendimiento del que históricamente daba un HDD tradicional.

- Infraestructura híbrida donde el flash se reserva para capas calientes y el HDD para volumen.

El punto no es reemplazar SSD, sino reequilibrar el stack: si el HDD sube su throughput, puedes descargar parte del trabajo “de volumen” sin pagar precio flash en todo.

Lectura TekNativo: el HDD no muere, se reposiciona

La narrativa correcta no es “HDD vs SSD”, es “HDD encontrando su siguiente forma” en una industria donde el ancho de banda se vuelve tan crítico como la capacidad, el disco mecánico necesita algo más que terabytes: necesita moverlos con menos fricción.

Y aquí está lo interesante, lo que parece una mejora técnica aislada encaja con el mismo fenómeno que está afectando el hardware de consumo (fechas, precios, disponibilidad) y empujando a la industria a buscar nuevas formas de escalar infraestructura. No porque falten ideas, sino porque las reglas del juego industrial cambiaron.